Failover cluster hyper-v

Нужно было развернуть стенд для демонстрации отказоустойчивого кластера с ролью hyper-v. В нашем случае не такой он уж отказоустойчивый, так как всего один коммутатор и одно СХД. Но для демонстрации технологии достаточно.

Задача: Развернуть тестовый отказоустойчивый кластер с ролью hyper-v (Failover cluster hyper-v)

Для реализации имеем.

- Dell Power Edge R710 – 2 шт (узлы кластера)

- EMC СХД – 1 щт (хранилище кластера)

- Коммуникации, (1G коммутатор)

- Диск с образом Windows Server 2012 Datacenter

Пошаговое руководство.

1. Для начала устанавливаем операционную систему на оба сервера.

После установки вводим их в домен, в нашем случае они получили имена

(00hyper-v-01 и 00hyper-v-02)

На каждом сервере мы имеем 4 Ethernet интерфейса, в нашем случае мы будем использовать по 3 на каждом сервере.

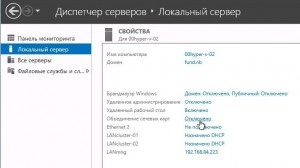

2. Называем интерфейсы для более удобного восприятия при администрировании.

LANmng – интерфейс который использовали для ввода в домен, этот интерфейс будем использовать для управления этим сервером и доступом ВМ в общую сеть.

LANcluster-01 и LANcluster-02 интерфейсы пока не имеют IP адресов, они будут объединены в группу и будут работать с кластером, то есть между узлами и СХД

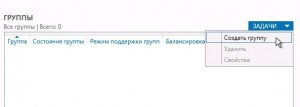

3. Теперь создаем группу сетевых карт. (NIC Teaming)

Диспетчер сервера – локальный сервер – объединение сетевых карт

Далее задачи – создать группу

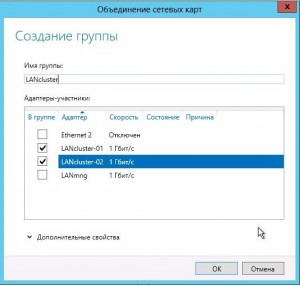

Далее выбираем нужные нам интерфейсы и задаем имя группы LANcluster

В итоге получаем новое сетевое подключение, в нем уже настраиваем нужные для нас сетевые настройки, IP, mask, Gateway.

Данную группу мы создали не сколько для практической, сколько для теоретической пользы. Так как у нас один коммутатор и он все равно остается узким местом нашей сети. А вот как выглядела бы схема с двумя коммутаторами объединенными в группу (port trunking).

После завершения настроек сети, переходим к поднятию нужных нам ролей на серверах.

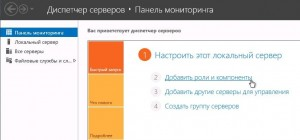

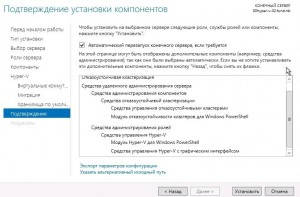

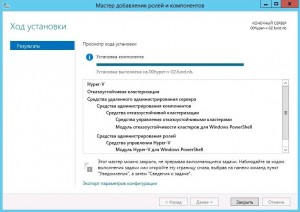

5. Поднимаем роль hyper-v и компонент отказоустойчивого кластера на каждом из узлов (серверов) по очереди.

Панель мониторинга — Добавить роли и компоненты

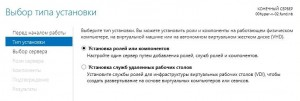

Выбор типа установки — установка ролей и компонентов.

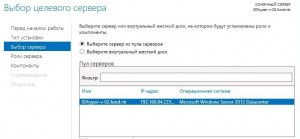

Выбор целевого сервера (когда через один узел, управляете несколькими серверами)

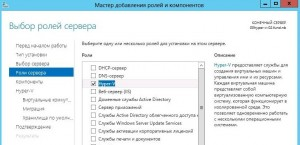

Выбираем роль hyper-v

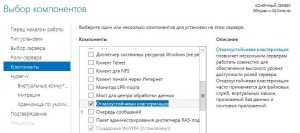

Выбираем компонент отказоустойчивой кластеризации

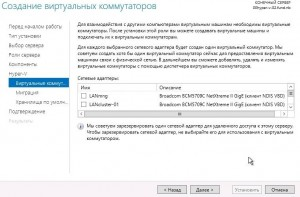

Пока не создаем виртуальный коммутатор, просто жмем далее

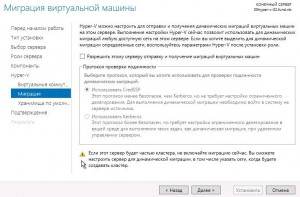

Миграцию тоже пропускаем, настроем ее уже в кластере

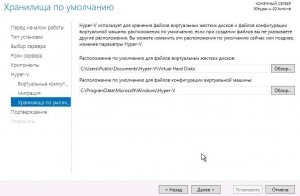

Хранилище оставляем по умолчанию, его мы потом заменим на СХД

Ставим галку Автоматический перезапуск и жмем установить

После перезагрузки должно появиться такое окно, жмем закрыть

После установки роли hyper-v и компонента кластеризации, переходим к настройке общего хранилища и кворум диска.

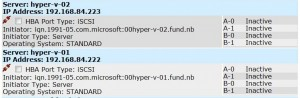

6. Заходим на EMC и создаем соединения по IQN

IQN серверов можно посмотреть зайдя в свойства ISCSI инициатора

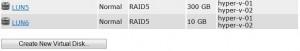

Далее создаем 2- виртуальных диска (LUN) и добавляем к ним наши сервера (В нашем случае СХД уже использовалось как file server и 5-ый рэйд менять было бы утомительно. Но в реальной среде для виртуализации лучше использовать RAID10)

В нашем случае мы установили

300GB для хранилища виртуальных машин (с возможностью расширения)

10GB для диска кворума (можно было бы и меньше)

Теперь подключаем созданные диски к нашим серверам (узлам)

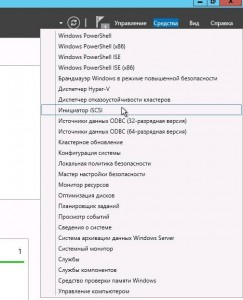

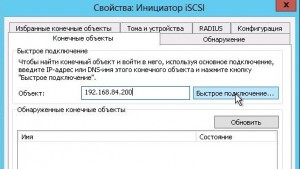

7. Заходим в инициатор ISCSI

Вкладка конечные объекты – вводим IPадрес EMC (СХД) и жмем быстрое подключение. (В нашем случае мы Не используем Авторизацию, но на боевых системах обязательно используйте сложные пароли а лучше RADIUS сервер. )

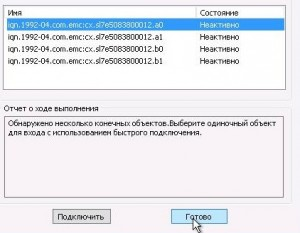

Жмем готово

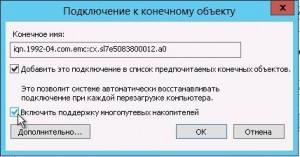

В нашем случае мы можем подключиться к нескольким SP портам, у каждого из них свой IP адрес. Подключаемся к одному самому верхнему, обязательно ставим галочку поддержки многопутевых накопителей.

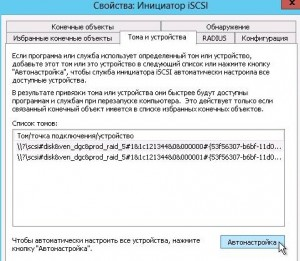

После заходим во вкладку Тома и устройства и жмем Автонастройка, должны появиться примерно такие две строчки.

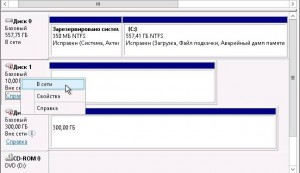

Дальше идем в управление дисками и видим два не определенных диска. Жмем правой кнопкой — в сети на оба диска

Создаем тома и называем их для более удобного восприятия при администрировании

После того как эти действия будут проделаны на одном узле, на другом узле достаточно сделать только быстрое подключение через ISCSI и во вкладке Тома и устройства нажать Автонастройка, Зайдя в управление дисками, так же нажать правой кнопкой – В сети, тома и названия дисков должны подключиться автоматически.

Переходим к сбору кластера.

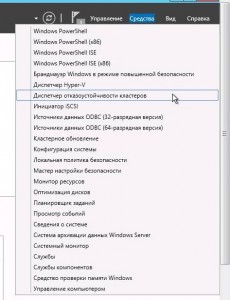

8. Заходим в диспетчер отказоустойчивости кластеров.

Жмем проверить конфигурацию

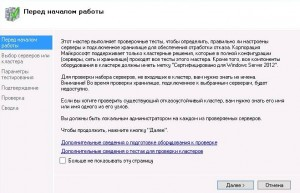

Появляется мастер, жмем далее

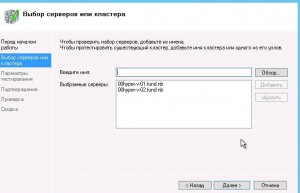

Добавляем наши сервера по DNS именам

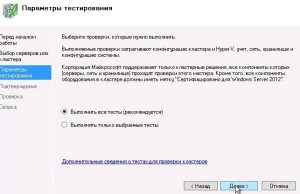

Оставляем галку на все тесты и жмем далее

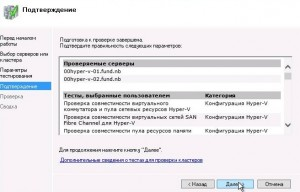

Жмем далее

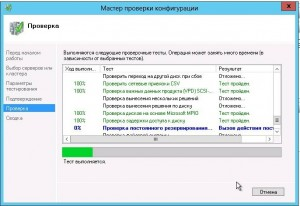

Процесс проверки конфигурации

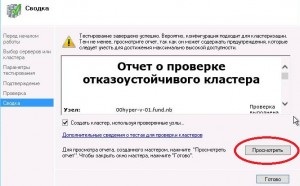

После окончания нужно просмотреть отчет

В нашем случае в отчете есть не критические предупреждения по сетевым настройкам

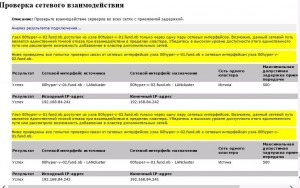

Рассмотрев подробней, мы видим такие предупреждения

Ну это мы сделали намеренно

Следующее предупреждение.

Проверка восприняла группу интерфейсов как один, и предупреждает нас о возможном узком месте нашего кластера

В любом случае это не критические ошибки и мы можем продолжить создание кластера.

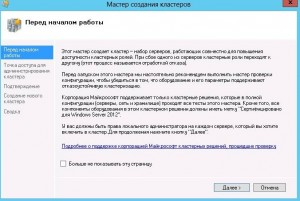

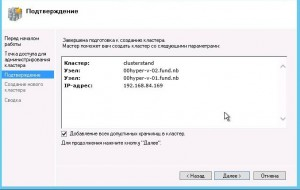

9. Создаем кластер (не важно, на каком из узлов начинать этот процесс)

Важно! При создании кластера нужно использовать учетную запись с правами на создание записей в Active Directory

Появляется мастер создания кластера, жмем далее

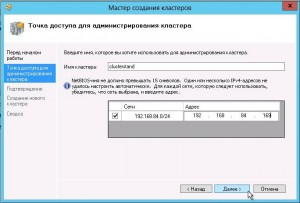

Даем имя и свободный IP адрес для нашего кластера

Подтверждаем параметры

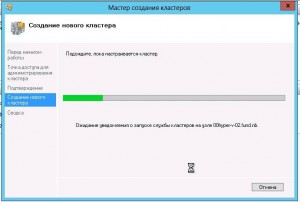

Процесс создания кластера

После создания кластера, в диспетчере отказоустойчивых кластеров мы видим наш кластер с его параметрами

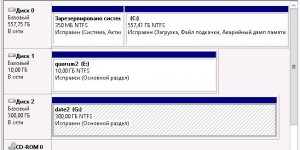

Проверяем правильность созданных хранилищ, диск под данные (общий том кластера) 300 GB а под диск-свидетель в кворуме 10 GB

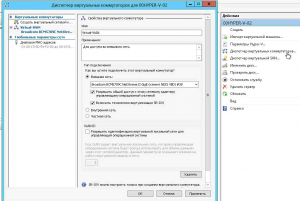

Теперь переходим в диспетчер hyper-v каждого сервера и создаем виртуальные коммутаторы, которые мы не создали ранее.

Делаем так:

Даем имя Virtual-WAN – это выход виртуальных машин в интернет и общую сеть.

Описание, дабы не путаться

Ставим галку Внешняя сеть

Выбираем интерфейс по имени устройства (в нашем случае интерфейс смотрящий в общую сеть LANmng — устройство #38)

И самое главное ставим галочку SR-IOV

(в предыдущем визарде эту галку поставить не было возможности, по этому, мы и отложили процесс создания виртуального коммутатора)

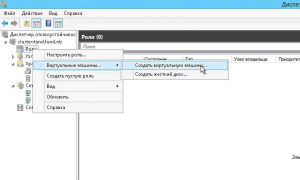

Теперь создаем виртуальную машину.

В нашем случае мы создаем виртуальную машину (высокой доступности) и по этому мы будем ее создавать через диспетчер отказоустойчивости кластеров.

Заходим туда и жмем правой кнопкой на Роли – Создаем виртуальную машину

Выбираем на каком узле будет создана ВМ

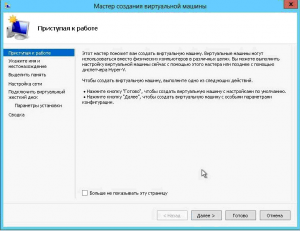

Окно визарда, жмем далее

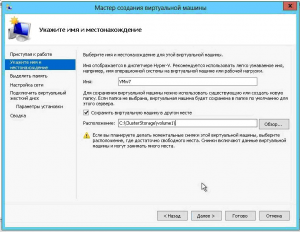

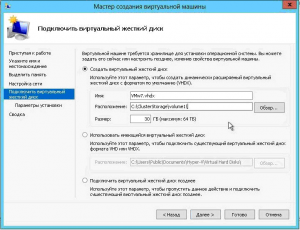

Даем имя

Выбираем место положение ВМ. На каждом узле кластера есть папка volume1 (это общий том кластера, то есть сетевое хранилище ) по этому пути:

C:\ClusterStorage\volume1\ выбираем этот путь жмем далее

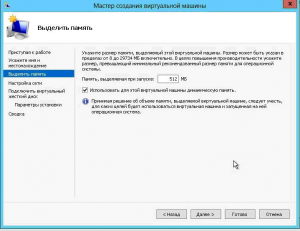

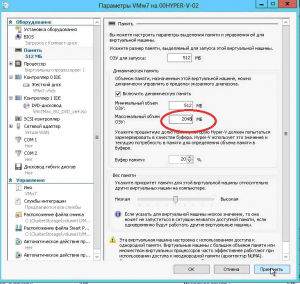

Выделяем память для запуска, ставим галку Динамическая память

(аппетит будем регулировать потом)

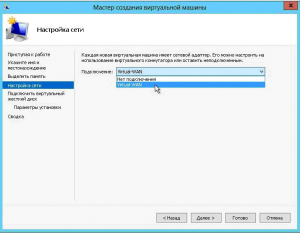

Добавляем сеть для виртуальной машины (созданную нами ранее)

Выбираем размер диска и располагаем его так же в volume1

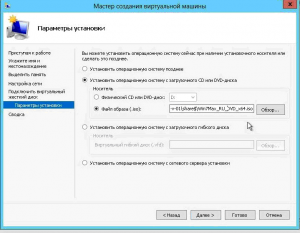

Указываем путь к ISO файлу установочного диска

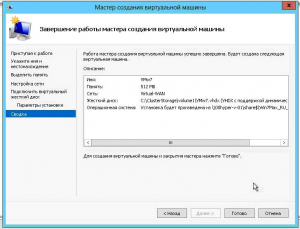

Проверяем созданную конфигурацию и жмем Готово

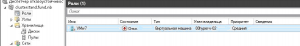

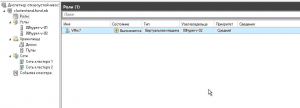

После чего мы видим созданную выключенную виртуальную машину

Сразу сбавляем аппетит и запускаем виртуальную машину

Далее производим стандартную установку, в нашем случае мы ставим ось, и даем ей IP адрес в нашей подсети.

Нажав на роли кластера, мы увидим нашу ВМ. В этом месте мы можем конфигурировать ВМ или перемещать ее между узлами или СХД. Так же можно выставить приоритет запуска после сбоя (высокий, средний, низкий)

В нашем случае стоит средний приоритет и давайте проверим как работает наш кластер, сможет ли он при сбое исполняемого узла перенести запущенную виртуальную машину на другой рабочий узел, не остановив работу.

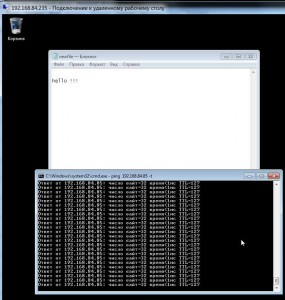

Для начала терминалимся на нашу новую ВМ, создадим файлик с текстом, не сохраняя его и запускаем пинг на какой ни будь хост

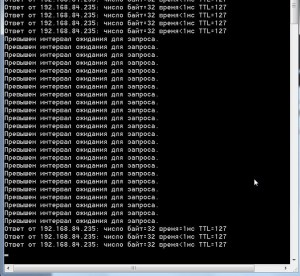

Так же запускаем пинг на ВМ в нашем случае ее IP 192.168.84.235

с любого хоста, вне кластера и виртуальной среды.

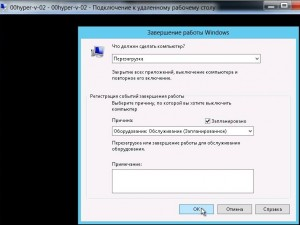

На рисунке выше видно что ВМ находится на 00hyper-v-02, по этому перезагружаем этот узел без всяких предварительных ласк

И видим что пинг до ВМ хоста пропадает, при чем на очень большой период времени.

Это показатели на EMC (очень отвратительные) на среде R310+ windows2008 они в несколько раз лучше, я их Вам обязательно представлю

Но это все из за канала связи, EMC подключен по 100 Mb портам + его использует куча народу. А сервер из которого я делал СХД подключен по 1000 Mb каналу + он ни кем не используется

Так же видим как ВМ запускается на 00hyper-v-01

Но что несомненно радует так то что, при отвисании сессии RDP на ВМ хосте мы видим такую картину.

ВМ работает, файл открыт и с актуальными данными, и что самое странное пинги на внешний хост не пропадали вообще

Ну вот мы и рассмотрели не большой стенд по отказоустойчивому кластеру на базе Windows Server 2012 Hyper-v Failover cluster hyper-v

Только полноправные пользователи могут оставлять комментарии. Аутентифицируйтесь пожалуйста, используя сервисы.